提到SEO,大家肯定不会陌生,一个优秀的项目离不开seo,它包含很多方面的知识,一般公司都会配置专门的SEO职位。

SEO的定义

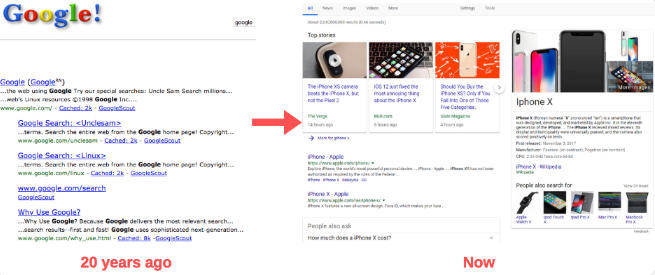

SEO是由英文Search Engine Optimization缩写而来, 中文意译为“搜索引擎优化”。SEO是指通过对网站进行站内优化和修复(网站WEB结构调整、网站内容建设、网站代码优化和编码等)和站外优化,从而提高网站的网站关键词排名以及公司产品的曝光度。通过搜索引擎查找信息是当今网民们寻找网上信息和资源的主要手段。而SEM,搜索引擎营销,就是根据用户使用搜索引擎的方式,利用用户检索信息的机会尽可能将营销信息传递给目标用户。在目前企业网站营销中,SOM(SEO+Sem)模式越来越显重要。

网友评论文明上网理性发言已有0人参与

发表评论: